Realmente no tenemos existe una definición formal de que es la AGI así que no tenemos un objetivo claro para llegar a ella. La forma en que actualmente tratamos de aproximarnos a ella es a través de los benchmarks (que como ya vimos que tiene sus propios problemas). Cada vez que se supera un benchmark aparece otro que sube el listón.

De hecho ya han sido varias las pruebas superadas que se suponía nos llevaban a la AGI:

- Ganar al ajedrez

- Ganar al go

- Superar el test de Turing

- Demostraciones matemáticas

- …

Y aquí seguimos sin nada que podamos considerar AGI.

Principalmente hay tres caminos que se mezclan:

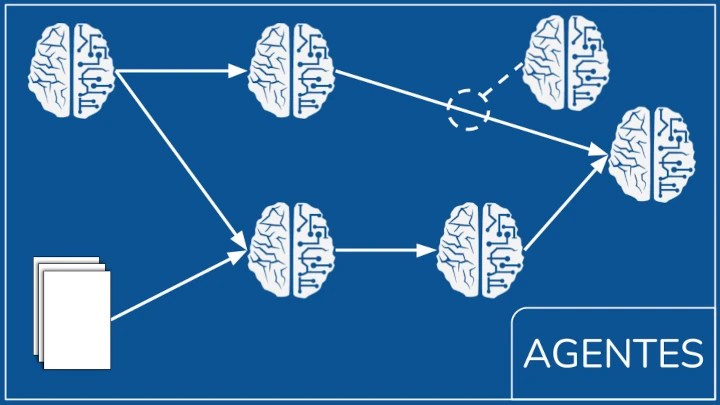

- Agentes: combinar varios modelos de lenguajes expertos en diferentes tareas.

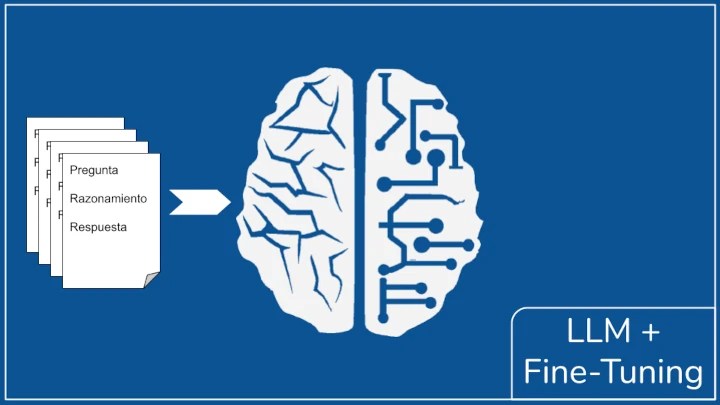

- LLM + entrenamiento: entrenar a un modelo de lenguaje para mejorar sus capacidades de razonamiento.

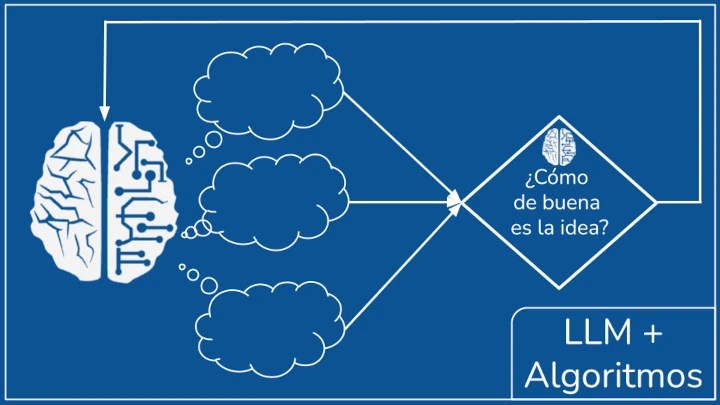

- LLM + algoritmos clásicos: el modelo de lenguaje genera múltiples caminos de razonamiento y se usan algoritmos clásicos para elegir cual se desarrolla.

No son tres caminos independientes si no que se pueden combinar para mejorar el sistema.

Además estos modelos pueden usar las siguientes

- Ingeniería de prompts.

- RAG

- Uso de herramientas (function calling)

- Generación y ejecución de código

No basta con conseguir la AGI, no todo es inteligencia:

- Comprensibles. No basta con que la respuesta sea correcta, tiene que estar claramente explicada para que sea comprensible. Por como funcionan los modelos de lenguaje esta explicación debe de producirse durante la generación de la respuesta. No puede producirse a posteriori. Ahora mismo lo que hay es un galimatías caótico. (un ejemplo clásico es ¿Cuál es el secreto de la vida el universo y todo lo demás?)

- Confiables. Tenemos que poder confiar en la respuesta de estos modelos, ahora mismo las alucinaciones hacen que no podamos confiar en ellos plenamente. Está relacionado con el punto anterior ya que si podemos comprender el “porqué” de la respuesta podemos aprender a detectar las respuestas erróneas.

- Razonamiento general: Es capaz de enfrentar problemas de todo tipo y crear estrategias para resolverlos. Un ser humano inteligente no es aquel que sabe la solución a un problema, es el que puede usar sus recursos para hallarla o aproximarse.

- Coste asumible: Estos modelos tienen que funcionar en una escala realista. Se estima que a O3 superar el test ARC-AGI le costó más de un millón de dólares. Por mucho menos puedes contratar a un grupo de expertos humanos. La necesidad de potencia de cálculo, recursos como la RAM y tiempo puede disparar el precio de estos modelos.

Agentes:

Como ingeniero es mi solución favorita.

En lugar de un único modelo usa varios modelos diferentes colaborando en un flujo de trabajo para hallar la solución. Esto permite modelos más pequeños especializados en ciertas tareas.

Pueden lanzarse varios flujos de trabajo en paralelo afrontando el problema desde distintos puntos de vista.

Ventajas:

- Modelos especializados y más pequeños

- Modelos más fáciles de entrenar

- Es fácil integrar diversas fuentes de datos y herramientas

- Es más entendible.

- Muy flexible.

- No es necesario entrenar todas sus partes solo la que necesites mejorar.

- Es fácil incluir “humanos” en el proceso

Problemas:

- Un fallo en un agente puede propagarse a los demás.

- Puedes usar agentes que verifican las respuestas. ¿Pero quién verifica al verificador?

- Comunicar a los agentes entre si. Usar lenguaje natural puede no ser la mejor opción.

- Requiere mucho trabajo y tiempo ir creando los diversos flujos de trabajo

LLM + entrenamiento:

Como fan de la ciencia ficción es mi solución favorita. Es la que más se aproxima a la idea que tenemos de IA inteligente.

Un modelo único capaz de generar respuestas inteligentes.

Ventajas:

- La idea es simple

Problemas:

- Requiere grandes modelos difíciles y caros de entrenar

- Grandes cantidades de datos de calidad. Es difícil encontrar buenos ejemplos de razonamiento.

- Ahora mismo su “razonamiento” no es muy entendible. A veces incluso llega a la respuesta correcta y la ignora.

- Caros de usar

Ejemplos:

O1, O3, DeepSeek V3, QwQ 32B

LLM + algoritmos clásicos:

Como desarrollador de software es mi solución favorita. Combina el razonamiento de los modelos de lenguaje con pasos intermedios que ayudan a guiar este razonamiento hacia las mejores ideas.

Ventajas:

- Se puede aplicar a modelos de lenguaje no entrenados para razonar.

- Reduce los costes de razonamiento

Problemas:

- ¿Cómo saber lo buena qué es una idea?. Generalmente se usan LLM entrenados para ello, pero no son buenos cuantificando las ideas.

Ejemplos:

Marco-O1

Problemas del transformer:

Los actuales LLM usan diferentes modificaciones de un transformer, una arquitectura de red neuronal que pese a sus buenos resultados impone serias limitaciones.

Para nuestro caso nos afectan principalmente dos:

- El contexto tiene un tamaño limitado. Pasado de cierto punto el modelo “pierde el hilo” del texto que está generando. Lo cual limita el tamaño del “razonamiento” que puede generar.

- El modelo de lenguaje no predice una palabra, predice una distribución de probabilidad de que cada una de las palabras (realmente, tokens) que conoce sea el siguiente. Pero de ese resultado elegimos solo una y esa información se pierde. Por lo que el modelo de lenguaje pierde toda la información entre cada palabra.