Uno de los mayores y más frustrantes problemas de los modelos de lenguaje (LLMs) son las alucinaciones. Le haces una pregunta y, con una seguridad pasmosa, te responde lo que quiere, a veces con información completamente inventada. Se han propuesto muchas soluciones para mitigar este problema, pero ninguna parece ser definitiva.

Sin embargo, hay quienes están abordando este desafío desde un ángulo diferente: las matemáticas. No salgas corriendo, no necesitas ser un experto para entenderlo. Vamos a ver de manera sencilla cómo conceptos como la entropía pueden ayudarnos a detectar y gestionar estas alucinaciones.

Un Vistazo Rápido: ¿Cómo «Piensa» un Modelo de Lenguaje?

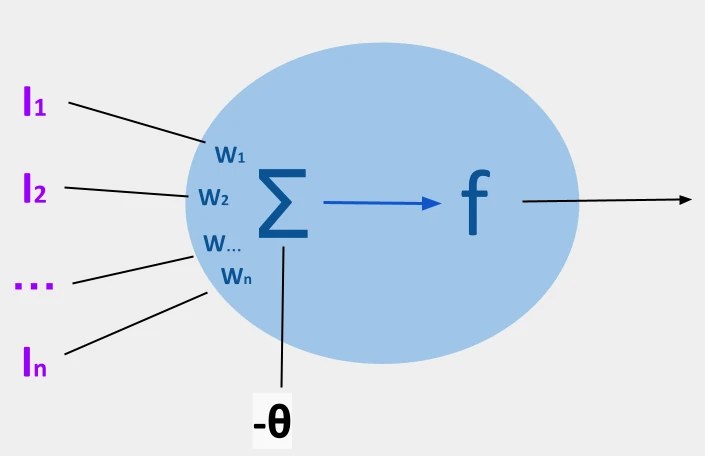

Antes de sumergirnos en la entropía, es crucial recordar cómo funciona un LLM en su nivel más básico. Cuando le das un texto, el modelo no solo elige la siguiente palabra o «token». Lo que realmente hace es calcular una puntuación para todos los tokens que conoce.

Estas puntuaciones, tras ser procesadas por una función (como SoftMax), se convierten en un listado de probabilidades. Es decir, el modelo genera la probabilidad de que cada token sea el siguiente más adecuado en la secuencia.

La Entropía: El Medidor de «Indecisión» del Modelo

Una vez que tenemos estas probabilidades, podemos calcular la entropía (concretamente, la entropía de Shannon de la teoría de la información). En este contexto, podemos entender la entropía como una medida de lo indeciso que está el sistema.

- Entropía Baja = Alta Seguridad: Si la mayor parte de la probabilidad se concentra en una o muy pocas opciones, la entropía es baja. Esto significa que el modelo está muy seguro de cuál es la respuesta.

- Ejemplo: Si preguntamos «¿Qué árbol da manzanas?», el modelo debería concentrar casi toda la probabilidad en el token «manzano». El sistema no duda, la entropía es baja y el problema está resuelto.

- Entropía Alta = Duda o Incertidumbre: Si la probabilidad está muy repartida entre múltiples opciones, la entropía es alta. El modelo está indeciso, y es aquí donde pueden surgir los problemas.

Cuando el Modelo Duda: Entropía Alta y Varianza

Una entropía alta nos dice que el modelo duda, pero no todas las dudas son iguales. Aquí es donde entra en juego la varianza de la entropía, que nos ayuda a entender cómo están distribuidas esas probabilidades. Esto nos permite distinguir entre dos escenarios clave:

Escenario 1: Duda entre Opciones Válidas

- Señal: Entropía alta, pero varianza baja.

- ¿Qué significa? El modelo está indeciso, pero entre un número limitado y concreto de opciones que tienen sentido. Las probabilidades están concentradas en unas pocas respuestas posibles.

- Ejemplo: Si preguntamos «¿Qué árbol da frutos?», hay muchas respuestas correctas (manzano, peral, naranjo…). El modelo dudará, repartiendo la probabilidad entre ellas.

- Solución posible: En este caso, no es que el modelo esté alucinando, sino que necesita más contexto o tiempo. Se pueden emplear técnicas como la «cadena de pensamiento» (Chain of Thought) o explorar las diferentes ramas de respuesta para que el modelo se aclare y elija la mejor opción.

Escenario 2: El Modelo está Completamente Perdido

- Señal: Entropía alta y varianza alta.

- ¿Qué significa? El modelo no tiene ni idea de cómo continuar. La probabilidad está distribuida de forma muy dispersa entre muchísimos tokens, sin que ninguno destaque claramente.

- Ejemplo: Si le preguntamos por una fruta inventada que no existe, el modelo no encontrará ninguna respuesta lógica y se quedará «perdido».

- Solución posible: Esta es una señal de alerta máxima. Indica que el camino que estamos siguiendo es muy poco probable que nos lleve a una respuesta correcta. La mejor estrategia podría ser retroceder varios pasos, reformular la pregunta o cambiar algunos parámetros de la consulta para intentar reconducir al modelo.

Resumen de la Estrategia

Podemos resumir este enfoque de la siguiente manera:

- Entropía baja: ¡Todo en orden! El modelo está seguro.

- Entropía alta y varianza baja: El modelo duda entre varias opciones plausibles. Hay que ayudarle a «pensar» y elegir.

- Entropía alta y varianza alta: ¡Alerta! El modelo está perdido. Es hora de volver a empezar o cambiar de rumbo.

Esta técnica no solo sirve para la corrección interna, sino que también tiene aplicaciones muy útiles para el usuario. Por ejemplo, se podría identificar rápidamente qué partes de la respuesta son menos fiables.

Limitaciones

Sin embargo, este método no es una panacea y tiene sus propios desafíos:

- Es difícil establecer un umbral numérico claro para definir qué es entropía «alta» o «baja».

- El contexto es clave. En tareas como la escritura creativa, un mayor grado de «alucinación» o es deseable.

- Las situaciones reales son mucho más complejas que los ejemplos simplificados.

Conclusión: Una Herramienta Más en la Caja

La entropía y su varianza son herramientas fascinantes que nos permiten asomarnos a la «mente» de un modelo de lenguaje y entender su nivel de certeza. No obstante, no son la solución definitiva a las alucinaciones.

Las causas de las alucinaciones son múltiples: prompts mal diseñados, datos de entrenamiento incorrectos o confusos, problemas durante el ajuste fino (fine-tuning), etc. La solución final no será una única técnica, sino un conjunto de medidas que, poco a poco, hagan a estos modelos más fiables y seguros. Este enfoque matemático es, sin duda, un paso prometedor en esa dirección.