Vamos a profundizar en un modelo que me parece fascinante: GLM Image. Aunque a simple vista podría parecer un generador de imágenes más, con sus casi 18.000 millones de parámetros, su importancia no radica solo en la calidad o el rendimiento, sino en su innovadora arquitectura y en lo que representa para la industria tecnológica actual.

Una arquitectura híbrida: Lo mejor de dos mundos

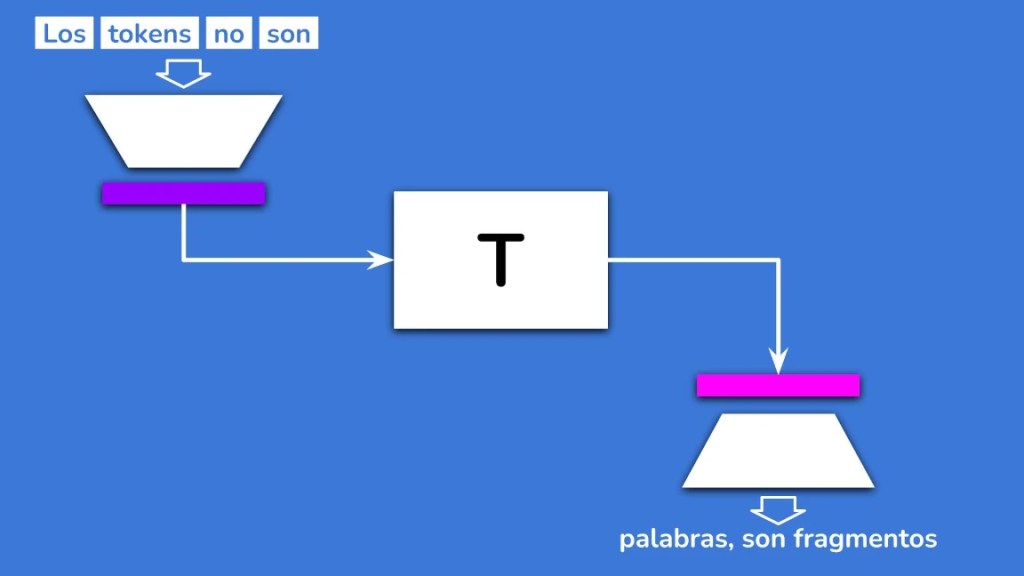

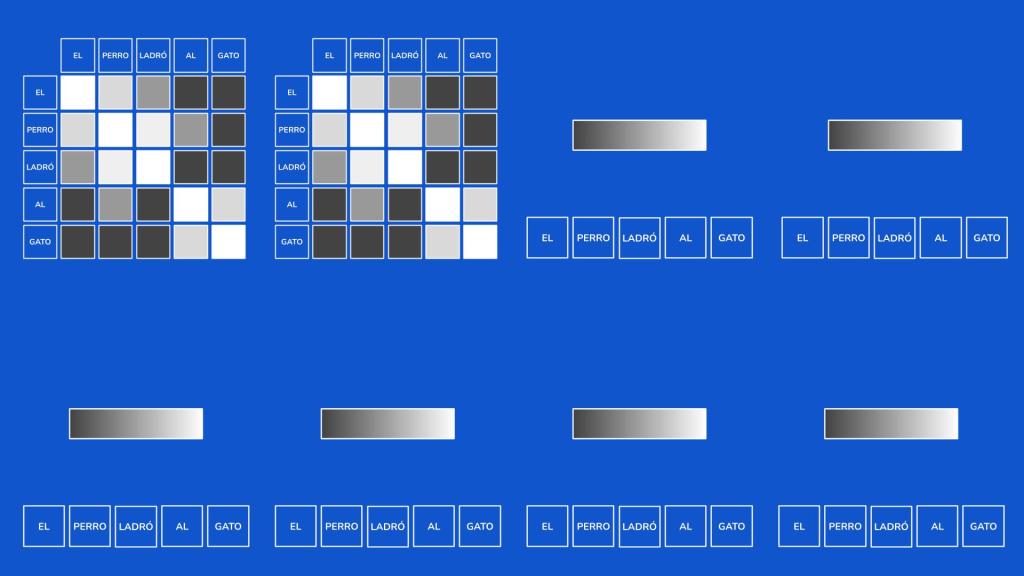

Lo que hace que GLM Image destaque es que no es solo un modelo autorregresivo ni solo un modelo de difusión; es una combinación de ambos. El proceso comienza con un modelo de lenguaje basado en GLM4 (de 9.000 millones de parámetros), el cual ha sido reentrenado para producir tokens visuales.

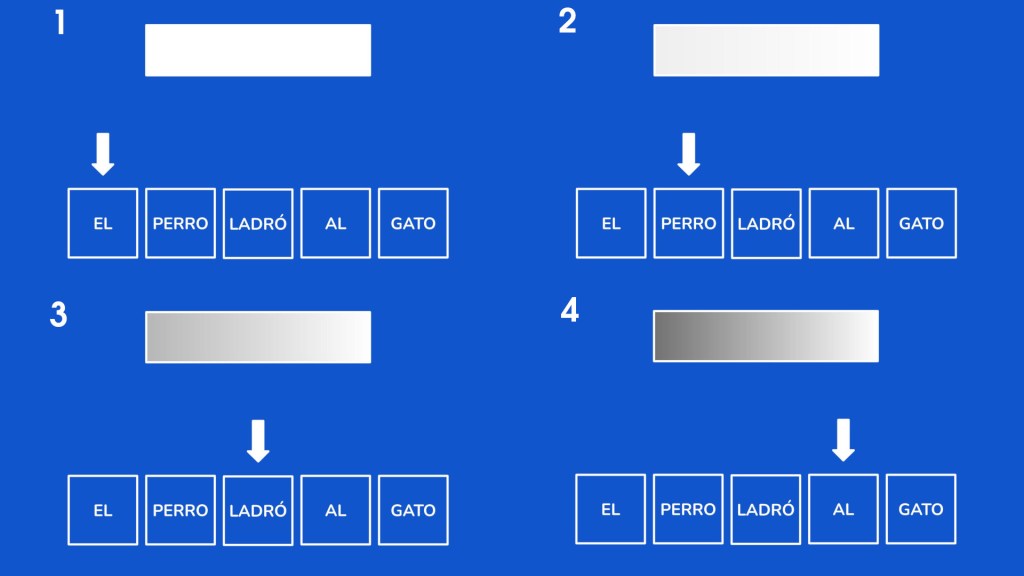

Este modelo autorregresivo se encarga de generar lo que llamamos datos de baja frecuencia (colores y texturas generales). Para ello genera de forma autoregresiva tokens que representan estos datos. Este proceso lo hace en dos pasos, primero crear una representacion de baja resolución formada por 256 tokes y finalmente crea una version de alta resolución con un total de entre 1000 y 4000 tokens.

Posteriormente, estos tokens pasan a un modelo de difusión que genera los datos de alta frecuencia, es decir, los detalles finos y la definición de la imagen. Es como si el modelo autorregresivo hiciera el boceto con las formas y colores base, y el de difusión se encargara de darle el acabado final y la nitidez.

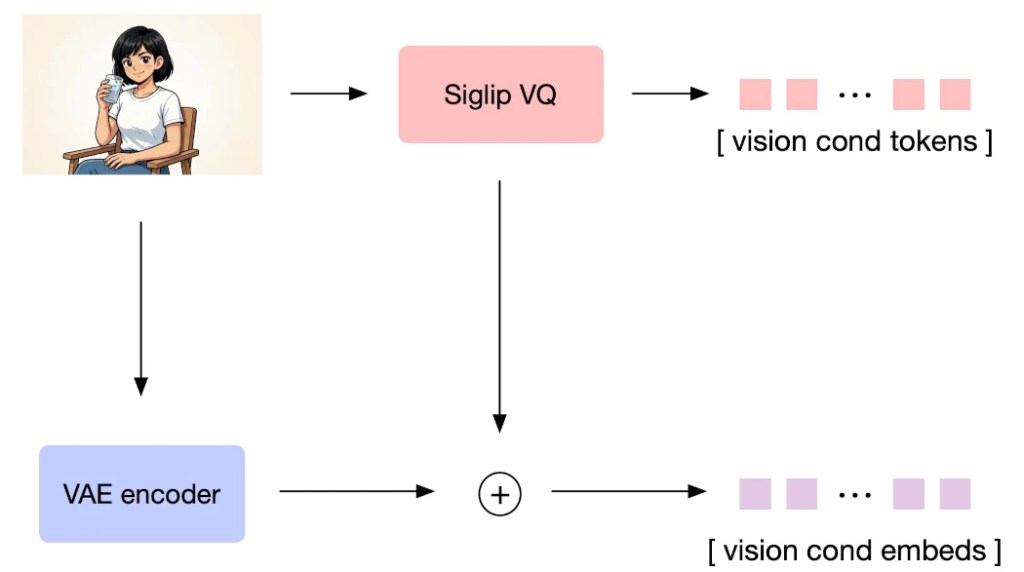

El reto de la edición y la codificación dual

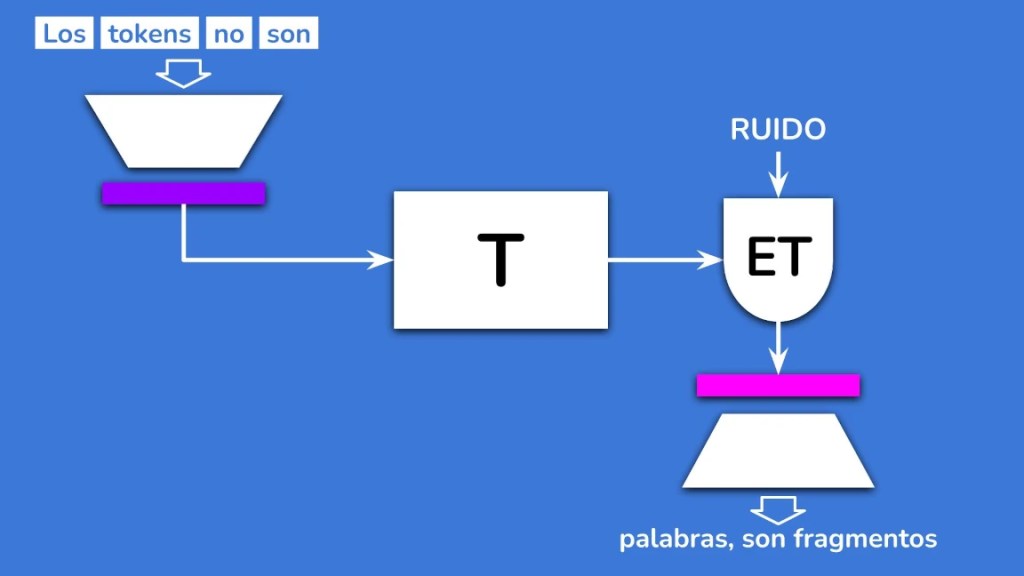

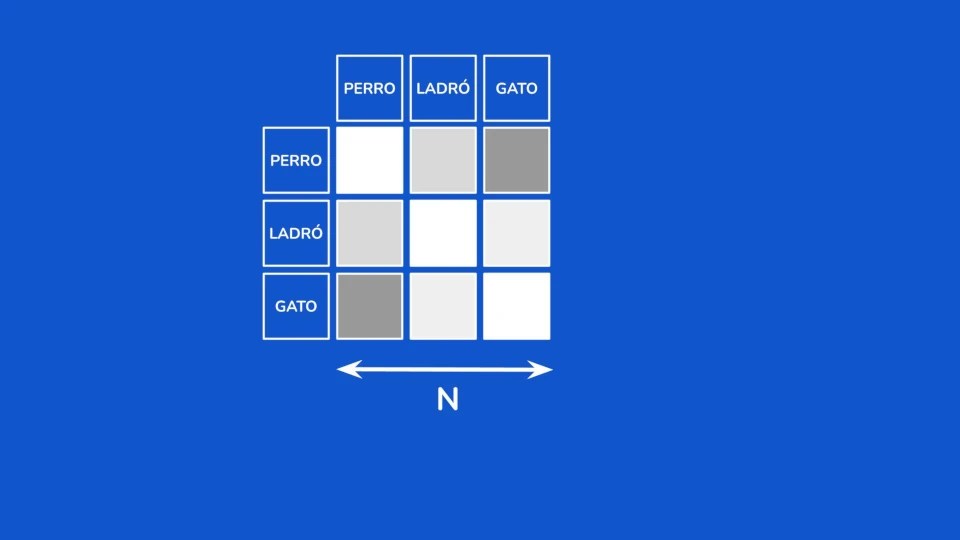

Cuando queremos editar una imagen o usar una como referencia, nos enfrentamos a un problema: el modelo autorregresivo tiende a perder detalles minuciosos. Para solucionar esto, GLM Image utiliza un sistema de codificación dual:

• Tokens Semánticos: Van al modelo autorregresivo y se centran en la descripción de lo que hay en la imagen.

• Tokens Visuales: Van directamente al modelo de difusión y se centran en el aspecto visual de los píxeles.

Esta separación permite que el modelo sea especialmente bueno manteniendo la coherencia, y lo detalles de las imágenes.

Para mejorar el aspecto y corrección de los textos que aparecen en las imágenes. Los tokens visuales son enriquecidos con otros relativos especificamene a los textos que deben aparecer en el resultado, con un énfasis especial en caracteres chinos.

Si quieres conocer el proceso con más detalle puedes ver este vídeo en mi canal de Youtube:

¿Por qué GLM Image es realmente importante?

Más allá de sus capacidades técnicas, este modelo es un hito por dos razones estratégicas:

1. El camino hacia los modelos «Omni»: Este tipo de arquitectura es un paso necesario para lograr modelos que puedan recibir y generar cualquier tipo de dato (audio, texto, vídeo) de forma fluida. Es una apuesta por los modelos multimodales totales que tanto nos apasionan.

2. Independencia de hardware: Quizás el punto más disruptivo es que GLM Image no ha sido entrenado con hardware de Nvidia, sino utilizando hardware de Huawei. En el contexto del conflicto tecnológico entre China y Estados Unidos, esto es una señal de alerta para Nvidia. Demuestra que las GPUs chinas están empezando a competir seriamente y que el mercado de la IA podría estar a punto de cambiar sus reglas de juego.

En resumen, GLM Image es una prueba de que el desarrollo de la IA no se detiene y que la competencia en hardware está más viva que nunca.